Creado por estudiantes de la universidad de Stanford, el sensor es (por ahora) de 3 megapíxeles. Pero funciona bien y es menos complicado que el método que había desarrollado Adobe con un propósito parecido.

El nuevo sensor, desarrollado por estudiantes de la Universidad de Stanford, tiene una resolución relativamente baja. Por tratarse de una prueba, el sensor es de “sólo” 3 Megapíxeles. Ya lograron resultados importantes, como generar un software que convierta las fotos a “ojo de mosca” en fotografías con datos sobre profundidad. Según comentan, el poder de proceso y consumo energético es todavía un poco alto, pero siempre se puede optimizar más adelante.

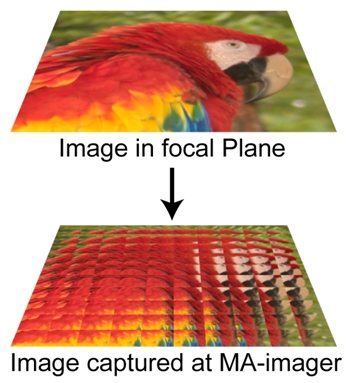

El nuevo sensor funciona agrupando píxeles en grupos de 16×16 y usando un mini lente para cada grupo. Con esto logran conseguir una imagen ligeramente diferente con cada grupo que, además, se sobreponga ligeramente con las adyacentes. En base a estas imágenes es que se “arma” la fotografía final y se le añaden los datos de profundidad. Esto significa que no son fotos 3D en el sentido que se pueden ver desde atrás, sino que se puede variar un poco el ángulo. Como si de un holograma se tratase, la foto se volvería una “ventana”.

Según sus creadores, los cambios a los sensores necesarios para aplicar esta tecnología no son tan grandes ni complicados. Gracias a esto esperamos ver productos pronto a la venta. También vale tener en cuenta que también el gigante Adobe está investigando el asunto por lo cual, gracias a la competencia, es probable que veamos los productos antes, de mejor calidad y a menor precio. Finalmente, el único “problema” de esta manera de generar fotos 3D es que necesita detalle, si sacamos a una superficie sin detalles la cámara no puede saber como recomponer la imagen.

- Así se forma el sensor con los micro lentes

- Una foto del sensor, por los micro lentes es que tiene un resolución inferior a sus hermanos no 3D