Dar instrucciones a un robot no es complicado. A decir verdad, hacemos exactamente eso con mucha frecuencia, y el rendimiento de los robots tiende a ser bastante bueno. Ahora, imaginen a un robot tratando de salvar a por lo menos una de dos personas. Si sus chances son similares, ¿qué pasa si tarda demasiado en tomar una decisión? En el Laboratorio Bristol de Robótica decidieron explorar esto con una trampa ética…

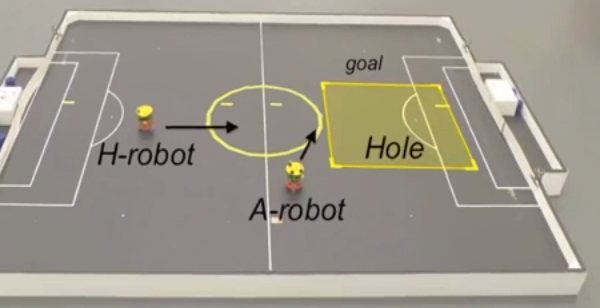

La Primera Ley de la Robótica trata de ser lo más contundente posible: Un robot no puede dañar a un ser humano, o a través de su inacción, permitir que un ser humano sufra daño. Cuando Asimov presentó la llamada “Ley Cero”, y extendió el significado de la primera ley para cubrir a toda la humanidad, surgió un dilema muy interesante, y es que en la práctica, los robots no parecen ser capaces de cumplirla. Mientras que un ser humano es algo concreto, y el daño en cuestión puede ser analizado y calculado, “humanidad” es algo abstracto, lo cual hace que el robot caiga en una trampa. En otras palabras: No puede decidir. Eventualmente, los robots de Asimov lograron procesar a su modo la Ley Cero, aunque en la vida real, los robots actuales tienen problemas incluso con individuos. Ante la pregunta de si un robot puede ser programado para “ser bueno” o “éticamente correcto”, en el Laboratorio Bristol de Robótica decidieron llevar a cabo un llamativo ejercicio: Un robot “A” debe salvar, de ser posible, a los robots “H” designados como humanos, evitando que caigan en un pozo.

En la primera fase del ejercicio, el “robot ético” funciona a la perfección, rescatando al humano del peligro. Al enfrentarse a la condición de salvar a dos humanos, el robot salva al primero, pero llega a la conclusión de que no puede salvar al segundo. Sin embargo, en el tercer intento el robot no puede decidir, causando que ambos humanos caigan en el pozo. Sobre un total de 33 pruebas, fueron catorce las veces que el robot ético quedó atrapado en la indecisión, causando la muerte virtual de ambos humanos. El experto en robótica Alan Winfield, responsable del proyecto, explica que su robot es una especie de zombie ético, y sólo puede reaccionar del modo en que lo hace, sin comprender sus acciones.

La pregunta de fondo permanece: ¿Puede un robot tomar decisiones éticas? Hasta ahora, la respuesta de Winfield es simplemente “no tengo idea”. El rendimiento de su zombie ético, que falló en más del 42 por ciento de los casos, nos hace pensar que la respuesta correcta es “no del todo”. Aún así, es algo a lo que los robots no pueden ni deben escapar. La falta de decisiones tiene el potencial de ser tan letal como un accidente, y eso nos hace pensar automáticamente en desarrollos como los coches que se conducen solos. Proteger la vida humana es la prioridad, pero llegado el caso, ¿qué vida vale más? Como un ejemplo extremo, ¿podría un sistema autónomo atropellar a alguien si eso implica proteger a los pasajeros?