El Media Lab del MIT ha desarrollado una interfaz gestual tridimensional que convierte en obsoletas a las pantallas multitáctiles que hemos visto hasta ahora. Esta institución ha presentado otras interfaces avanzadas en el pasado, pero parece que este sistema en 3D capaz de interpretar los gestos es realmente revolucionario. La pregunta es inevitable, ¿puede este sistema poner en riesgo al proyecto Natal de Microsoft?

Parece que el futuro de las interfaces de usuario pasa por los gestos. Tiene sentido: día a día interactuamos con otros humanos mediante gestos, y usamos herramientas “tocándolas”. Las interfaces actuales, basadas en teclados, ratones o palancas son poco naturales. La tecnología ha avanzado lo suficiente como para que el poder de cálculo disponible alcance como para que un ordenador -además de mostrarnos el contenido de un correo electrónico- pueda entender nuestros gestos. De popularizarse, este tipo de interfaz hará posible que cualquier persona, prácticamente sin ninguna clase de entrenamiento previo, pueda operar un ordenador.

Cuando los ingenieros construyen una pantalla capaz de reaccionar a los “toques” del usuario o interpretar sus gestos, necesitan incluir una membrana resistiva o capacitiva transparente que la recubra. Esta membrana hace las veces de “piel” de la pantalla, recogiendo las coordenadas en las que el usuario apoya sus dedos y enviándolas al ordenador para que actúe en consecuencia. En el caso de las interfaces gestuales, se necesitan algunas cámaras de vídeo capaces de “ver” qué hace la persona que se encuentra frente de la pantalla. Este enfoque es mucho más complejo –eso explica por qué disfrutamos desde hace años de dispositivos táctiles pero no gestuales- y generalmente se ponen cámaras en los biseles del monitor o detrás de la pantalla. Ninguno de los dos sitios mencionados son particularmente eficientes: el primero adolece de “puntos ciegos”, y el segundo degrada la imagen que se muestra en la pantalla.

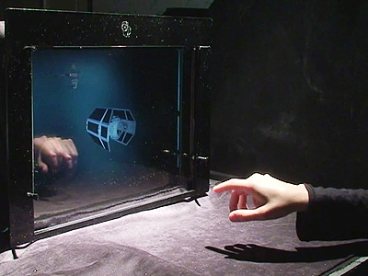

¿Por qué, BIDI Screen, el sistema del MIT es tan bueno en lo que hace? Porque sus ingenieros han integrado cientos de pequeñas cámaras entre los puntos emisores de luz de la pantalla. En lugar de tener un LCD y cámaras separadas, se tiene una misma superficie que es capaz de emitir luz (y formar imágenes) a la vez que puede “ver” lo que tiene enfrente. El vídeo que acompaña esta nota es lo suficientemente claro como para entender el concepto. Lo cierto es que la interfaz del Media Lab permite la “manipulación virtual de objetos en tres dimensiones” de una forma que nunca habíamos visto. ¿Es mejor que Natal? Es difícil saberlo. Lo que tenemos hasta ahora son dos “demos” creadas por los autores de cada sistema, en la que cada uno muestra lo mejor que su dispositivo puede hacer. Lo único cierto es que son intrigantemente diferentes. Habrá que esperar a que se conviertan en dispositivos de consumo para finalmente saber cuál idea es la mejor. Por lo pronto, solo podemos esperar.