Es algo muy difícil de creer, especialmente si tenemos en cuenta cómo han evolucionado los ordenadores en los últimos años, y cómo evolucionarán en las décadas por venir, pero de acuerdo a una publicación hecha por dos físicos de la Universidad de Boston, si se mantiene constante la actual Ley de Moore, el máximo de velocidad posible en un ordenador será alcanzado en unos 75 años. No se trata de una limitación de hardware o software, sino de algo mucho más elemental. Esa limitación en la velocidad no podrá romperse de ninguna manera, como no se puede superar la velocidad de la luz, ni alcanzar el cero absoluto.

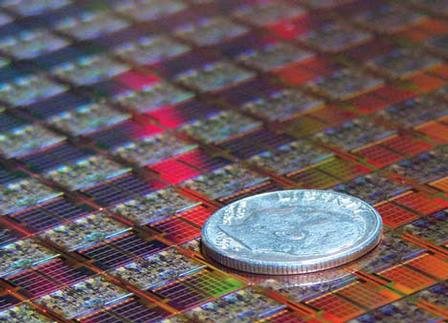

Estamos cada vez más cerca del límite de miniaturización para los métodos actuales de fabricación basados en el silicio. La nanoelectrónica jugará un papel crítico en los años por venir, al mismo tiempo que se seguirá explorando el enorme potencial que ha demostrado el grafeno hasta ahora. También tendrá su lugar la computación cuántica, que se encuentra dando sus primeros pasos. Sin embargo, sólo se necesitará menos de un siglo para alcanzar una velocidad en los ordenadores tan alta, que sencillamente no se podrá superar. Esto es de acuerdo a una publicación hecha por los físicos Lev Levitin y Tommaso Toffoli de la Universidad de Boston, en Massachusetts.

A través de su publicación, ambos físicos han presentado una ecuación que permite determinar cuál es la unidad mínima de tiempo que se necesita para llevar a cabo una operación de computación, y a partir de allí han podido calcular cuál es el límite máximo al que deberán enfrentarse todos los ordenadores tarde o temprano. Si seguimos la teoría, la ecuación determina que por cada unidad de energía, un ordenador cuántico "perfecto" podría ejecutar diez mil billones de operaciones por segundo (10^16, convertidas del "ten quadrillion" inglés) más de lo que pueden hacer los procesadores más rápidos que existen hoy en día. Si se sigue a rajatabla la ley de Moore, se alcanzará esa velocidad en aproximadamente 75 años, llegando a un límite natural de velocidad que no puede ser quebrantado bajo ninguna circunstancia.

Esto sería una especie de restricción equivalente a la velocidad de la luz, o al cero absoluto. Lo que puede sonar todavía peor, es que hay muchos expertos que le dan a la Ley de Moore una vida mucho más corta. De hecho, se estima que la ley no podrá sobrevivir más de dos décadas, aunque no será debido a esta limitación, sino que en realidad se asocia con la miniaturización de los transistores. Entonces, si aumentar el reloj de un procesador no funcionó, y agregar núcleos indefinidamente tampoco nos dará la velocidad que queremos, ¿qué se puede hacer? Las leyes de la física son las que nos limitan, por lo que habrá que comenzar a revisarlas. Puede que en el futuro algunas mentes privilegiadas puedan encontrar una fisura allí donde no podemos verla ahora, y abrir la puerta a toda una generación futurista de ordenadores.

Creo que seria lógico pensar que estos científicos de la universidad de Boston se basan en la tecnologia actual que hoy conocemos y en las leyes de la fisica que existen hoy en día. Como todo en el mundo se evolucionará, i los ordenadores del futuro lejano quizás no tendran nada que ver con los de ahora. Al igual que las leyes de la física son revisdas cada cierto tiempo debido a nuevos descubrimientos y nuevos materiales y formas de la materia que se van descubriendo, las leyes de fisica se reescribiran o se perfeccionaran con los años. Lo que hoy es imposible, mañana es probale y pasado mañana es evidente. Asi que creo en un futuro prometedor en el mundo de la informática.

La velocidad de la que hablan es absolutamente asombrosa, pero cuando la tengamos, querremos mas, si los estados cuanticos nos permiten mas valores para el actual sistema binario, es decir que podamos conseguir 4 estados (como actualmente se persigue), seria una manera de ganar proceso sin recurrir a la miniaturizacion.

Y que tal si en vez de 1 ordenador cuántico perfecto se ponen 2 ordenadores cuánticos (casi) perfectos conectados entre si? La miniaturización, el procesado cuántico, etc, se refieren a la unidad mínima de proceso serie… Porque no abrir miras y pensar en procesos paralelos? si N es el número de cálculos por unidad de tiempo, K·N es el total de cálculos que se pueden hacer en una arquitectura paralela, y K es un entero sin límite de rango.

El proceso paralelo no tiene límites.

Si que los tiene, y muchos. Simplemente el tiempo que tardan en comunicarse ambos reduce la rendimiento final.

Hoy en dia, por ejemplo, no es lo mismo un procesador a 8000mhz que un dual core 4000mhz. EL rendimiento aproximado serian unos 7500mhz en el segundo, y si vamos a un quad core y sucesivos va decayendo.

75 años… jejeje… ordenadores cuanticos… jojojo!!! si en el mundo seguimos asi en menos de una decada vamos a volver a contar con los dedos, si es que sabremos contar…

Jajaja… La verdad que tienes razon….nos preocupamos de que si en 50 años o si en 100 años …y como vamos en este mundo no llegaremos ni a la esquina….

No estoy seguro, pero creo que se refiere a la unidad minima de tiempo (igual que no existe nada mas pequeño que la particula mas pequeña del universo tambien existiria la fraccion minima de tiempo del universo) que por fisica se pudiera dar en el universo, que haria que una particula determinada no pudiera cambiar de estado o posicion mas rapido, pues pasaria de moverse muy rapido a teletransportarse de forma instantanea. Es de suponer que un ordenador sujeto a las leyes de este universo tiene unos limites de funcionamiento definidos imposibles de superar…

Y si las partículas de este ordenador cuántico, en vez de moverse de un lado a otro para realizar un proceso en una cantidad N de unidades mínimas de tiempo, se hace que viajen en el tiempo, cosa que la respuesta simplemente ya esté en el mismo momento que se hace la petición de realizar tal proceso.

Suponiendo que todo demore una unidad de tiempo t.

Pedrito quiere sumar "2+2" en tiempo t1 y da "Aceptar", esto realiza el proceso y obtiene como solución "4" en el tiempo t2 pero, esta solución no se le dá a Pedrito en el tiempo t3 sino que viaja al pasado al tiempo t0 y se le visualiza a Pedrito en el tiempo t1, es decir, nunca hubo un retardo.

"640 k deberían de ser suficientes"

Dijo una persona antiguamente…

Ese fue nuestro viejo amigo Bill Gate ^^

sus motivos tendran… pero yo no veo porque tiene que haber un minimo para el tiempo empleado en realizar una operacion… estaria bien conocer los supuestos en los que se han basado para deducir eso…

Son puras especulaciones, y más si tenemos en cuenta que en informática pensar a más de 20 años es un puro disparate.

Ellos dicen eso, y yo por decir digo otra cosa, si tenemos una bola del tamaño del sol de pura energía de procesado cuántico que administre una súper civilización, ¿que el rendimiento se reduce por el proceso en paralelo? Si, pero no es exponencial esa reducción para nada.

Quizás exista un límite de velocidad y de cómputo paralelo por concepto, entendiendo como concepto aquel que no puede ser procesado mientras el anterior no termine, pero de todas formas quien sabe que leyes físicas u otras nuevas que se descubran se emplearían, y además, el crear entes de procesado crearía una inteligencia común como ocurre con la especie humana, quien sabe, se podrían crear entes pensantes sin cuerpo, en cantidades de miles de trillones superior a la humana, y sería un ultra paralelismo.

En resumen, lo publicado no vale para nada. Y esta vez es la primera que critico a neoteo, considero que es una gran revista, pero esto es sólo especular o ciencia ficción, propias de prensa de fantasía.

A que se las pongo fácil.

Ley #1 y más importante a notar:

Nada, ni nadie, se puede mover a la velocidad de la luz.

Por ende, para que una computadora procese un dato, tiene que viajar desde el dispositivo de entrada, al procesador y del procesador de regreso al dispositivo de salida, lo que nos dá como límite, al menos cómo resultado 2*la velocidad de la luz, y ningún procesador podrá atravesar ese límite, siempre y cuando por supuesto, nadie descubra cómo vencer la velocidad de la luz.

Claro que si alguien hace eso, probablemente lo que menos nos interese en ese momento sea hablar de ordenadores XD

¿que entiendes que es un procesador? El mismo universo puede ser un procesador, y el tiempo puede ser la determinación de cada ciclo, al encontrarse en estado indeterminado y obligar a definirse

mmm, pues la verdad no entiendo tu punto, aunque tampoco entiendo como puedes acusar a neoteo de prensa de fantasia y al mismo tiempo salir tu conque el mismo universo pueda ser un procesador…

En fin, no se porque les saca tantas ronchas a todo mundo que alguien diga que no se puede hacer algo, probablemente es un síntoma como el de la gente que le tiene miedo a la muerte, por el simple hecho de que les da un tremendo sentimiento de impotencia para marcar su propio destino, de igual manera pareciera que aquellos que sienten hasta vértigo de pensar que existen cosas imposibles, como en este caso curiosamente el manejo de la palabra "límite", que bien lo dice en su uso matemático, no se puede rebasar, pareciera que hace algunas personas pensar o sentir que los limitados son ellos.

Yo les diría a todos, ¡tranquilos!, que da igual que exista o no un límite de velocidad, mientras no exista un límite de ingenio, y ese SI que pienso que no existe, lo de menos es llegar a un punto en el cual no podamos hacer computadoras más rápidas, el detalle estará en ser lo suficientemente ingeniosos para seguirles sacando más y más provecho. Es cómo se los podría decir cualquier maestro de programación, ¿para que te sirve un super ordenador, si tu código es un reverendo caos que no aprovecha ni el 1% del ordenador?

Prensa sensacionalista por el titular sobre una cosa que no tienen ni idea:

Los ordenadores tienen un límite absoluto

Cuando debería haber sido: ¿Los ordenadores tienen un límite absoluto?

Y lo que hice con la anterior respuesta era ponerme a fantasear, que es lo que hace el artículo. Saludos

Por cierto, aclaro y para no dar mal rollo que cuando digo que "sobre una cosa que no tienen ni idea", no es por mal ambiente ni descalificando, sino que nadie tiene ni idea (ni el mejor especialista) de lo que depara el futuro a tantos años como para poner un titular así de rotundo por más que se aclare después, eso es clásico de la prensa de otro estilo. Y bueno dejo el tema que tampoco tiene tanta importancia

¬¬ miren de esta forma … en el pasado los fisicos ya se equivocaron al pensar primero que el atomo era la unidad indivisible y de ahi su nombre, luego se descubrieron los Quarks y leptones [que son particulas subatomicas], asi que cuando los fisicos estos dicen "la unidad mínima de tiempo que se necesita para llevar a cabo una operación de computación" pues pasara lo mismo que con el atomo y todos estaran felices XD, ademas de que me parece super extraño que sacaran una ecuacion para saber cual es el tiempo minimo para llevar a cabo una operacion de computacion y como bien dijo un lector aqui, "se basan en lo que existe", porque hablan de la velocidad maxima de 1 ordenador cuantico perfecto o sea, si no hubiera existido los ordenadores cuanticos se basarian en el ordenador electronico XD o sea es subjetivo esto …

Como se nota que Victor_Js ha estado en clase de Arquitecturas Paralelas,…xDD

Pues si, no andas muy descaminado y no es broma, pero no voy a contar aquí mi vida

tal vez no podemos construir procesadores mas rápidos que eso, pero sí podemos hacer que el tiempo valla mas lento… dejemos los procesadores quietos y todo lo demás movámoslo a velocidades cercanas a la de la luz…

asi como ubo un cambio del bulbo al transistor tal vez en el futuro existan los transistores cuanticos xD

Recuerdo que esto ya lo había pensado Intel por este motivo invento el High K que aunque esta basado en super conductores de silicio con otros metales han cambiado la formula y por lo tanto ya no estamos platicando solo de silicio. Cuando los procesadores sean de atomos de silicio, encontraran como hacerlo con quarks, bueno claro ya no estamos hablando de silicio si no de algo mas pequeño que atomico. buen articulo 🙂

Vamos que cuando ya no se puedan hacer mas pequeños, ni mas rapidos, ni haya espacio en el planeta para hacerlos mas grandes, no se podran hacer ordenadores mas potentes…

Creo que aun falta bastante mas de 75 años para esto…

Me ha gustado el contenido en debate que se ha generado la mayoria de los comentarios han sido buenos es la razon por la cual esta es mi pagina favorita se aprende mucho con leer un rato aqui saludos

baaa, no me sorprende.. hemos avanzado bastante en cuanto a procesadores se refiere..

pero… es un circulo vicioso, creamos aplicaciones que requieren un procesador más potente.. y más potente.. en fin, va a ser casi lo mismo que ahora, solo que con números sorprendentes, pero rendimiento similar o igual..

muy buen articulo sobre todo los comentarios XD no creo que lleguemos a 75 años XD la tierra ya esta en muere XD saludos!!

creo que la propuesta de decir que quedan 75 años puede ser muy probable pero se está basando en la tecnología que disponemos hoy, quizás cuando pasen los 75 años poseamos otras tecnologías que permitan ser los ordenadores aún mejores.

pero desde mi punto de vista creo que hay leyes que no se pueden superar

saludos gran revista

Bueno y donde dejan el tiempo y el espacio he, he… las brechas de descubiertas por los sintificos. Lo único que hay que hacer es tomar los ordenadores viejos, montarlos en un acelerador del tiempo y listo súper velocidad sin limites… jejejeje… claro que primero hay que inventar algo que modifique el tiempo en espacios pequeños y todo eso, no les parece?