La gente de Nvidia está llevando a cabo la edición 2013 de su GPU Technology Conference, que suele estar orientada a desarrolladores, pero que nunca nos deja con las manos vacías. Tanto Nvidia GRID como la serie Tegra de SoCs han tenido un lugar en el keynote, sin embargo, nuestra atención se dirige hacia el nuevo GPU que el gigante verde de Santa Clara tiene planeado. Su nombre es Volta, y aunque habrá que esperarlo por varios años, los adelantos en sus especificaciones nos hacen creer que semejante demora bien valdrá la pena.

La conferencia GTC de Nvidia se extenderá hasta el día de mañana, pero después de que el CEO Jen-Hsun Huang tomó el escenario para realizar el keynote correspondiente, casi se puede decir que todas las novedades han sido cubiertas. Como era de esperarse, Huang habló de Nvidia GRID, que mordió un poco el polvo luego de que Sony comprara Gaikai, y de la plataforma móvil Tegra, con sus sucesores Logan en 2014 y Parker en 2015. Pero también hubo novedades en el espacio de las tarjetas gráficas. Nvidia ha decidido extender su mapa de desarrollo, revelando así una futura generación de GPUs bautizada Volta, en honor al inventor de la batería.

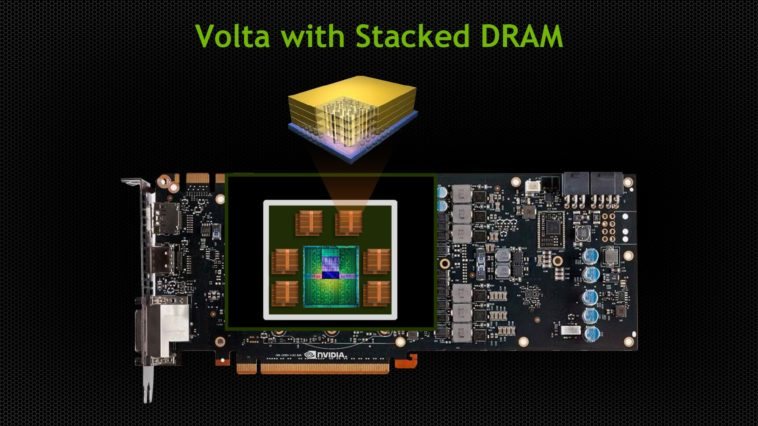

La información sobre las especificaciones de Volta no es muy amplia que digamos, pero entre lo poco que compartió Nvidia, tal vez el punto más interesante sea la “DRAM apilada”. ¿Qué significa esto? Que los módulos de memoria serán colocados uno sobre el otro, lo que permite reducir drásticamente la distancia entre los módulos y el GPU, tanto que incluso serán colocados dentro del mismo paquete. El concepto no es nuevo, pero lo cierto es que ha habido muy pocos ejemplos en mercado, siendo el más reciente el de la PlayStation Vita. Al instalar la memoria tan cerca del GPU, Volta puede utilizar buses más anchos y veloces, además de reducir la latencia.

¿Qué tan rápidos y anchos? El objetivo de Nvidia para Volta es de un terabyte por segundo. Si comparamos esto con la recientemente lanzada GeForce GTX Titan, estamos hablando de un aumento del 300 por ciento, mientras que el bus debería estar en el orden de los 1.024 bits como mínimo. No hay dudas de que Nvidia se tomará su tiempo con Volta. Antes de llegar a ese GPU, los entusiastas van a encontrarse primero con Maxwell, el sucesor directo de Kepler. Maxwell fue anunciado en 2010, y se esperaba que llegara al mercado este año, pero Nvidia ha ajustado su lanzamiento para el año 2014. ¿Qué trae Maxwell consigo? Nada menos que memoria virtual unificada, lo mismo en lo que está trabajando AMD con sus plataformas de computación heterogénea. La única duda que me queda sobre Volta es cómo va a hacer Nvidia para que ese monstruo no derrita nuestras carcasas.

La respuesta es simple: Lo venderá a un precio prohibitivo, así no derretirá nuestras carcasas. Menos mal que hemos llegado a un punto en el que las gamas medias-bajas son auténticos maquinones.

La cosa es simple, tienen que salir a anunciar cosas para dentro de 3 años porque en lo inmediato han perdido a todo el segmento de consolas y por otro lado la linea Tegra4 para moviles no ha tenido casi aceptacion entre los ensambladores, viendose copado el mercado por Qualcomm entre otras. Las cosas no parecen ir muy bien para NVidia.

esta obvio que se prepara para abatir a la next gen… ahora como todo esta saturado en graficos ya empiezan las propagandas cazabobos que al fin y al cabo van a ser una "titan" mas en su momento…. UNA PREGUNTA APARTE COMO HAGO PARA QUE ME LLEGUE AL MAIL O ALGO ASI CADA VEZ QUE ALGUIEN ME CONTESTA AQUI EN NEO TEO??

Realmente NVIDIA no sabe como hacer para volver a recuperar terreno y que fue el lider antes de que AMD lo supere, cada GPU nuevo que sale cuesta quizas 10 veces mas que un producto de AMD de la misma, Nvidia para ganar terreno tiene que bajar sus precios y no ser un mal perdedor.

#4 Nvidia sigue siendo el líder, ahora eso si, esta perdiendo cuota de mercado.

Con el panorama actual, hay varios ensambladores de tarjetas gráficas y éstos deciden la cantidad de RAM que llevará la tarjeta gráfica, entre otras cosas. Si se integra la RAM en el núcleo, se elimina esa posibilidad, por lo que, o deja de haber versiones con diferentes cantidades de RAM (lo que favorecería al consumidor, pues ya no podrían engañarle metiéndole mas RAM a un núcleo de gama baja para hacerle creer que es mejor que uno de gama media con menos RAM), o le meten la máxima posible y mediante unos solder-jumpers permiten a los fabricantes limitar la cantidad disponible (haciendo que el consumidor pague más por menos).

La verdad que el titulo es como minimo tendencioso. "LA GPU DEL FUTURO" deberia decir algo como "El futuro GPU de NVidia".

nuvo blog sobre electrónicay automática, muy interesante http://electronsecrets.blogspot.com.es/2013/03/iniciacion-al-matlab-2.html?spref=tw

Lo unico que veo de esto, es que si miran con detalle el grafico Roadmap, se ve claramente que la linea de potencia año a año va reduciendose (no aumentando ni manteniendose). Por lo cual, cada vez vamos a pagar por menos rendimiento.

#9 Bueno, por otro lado "Volta, el gpu del futuro" no tiene año debajo de él… puede ser 2015 como 3010. La ventaja de AMD al apoyar a arquitectura HSA esta buscando ir por un standard y no cortarse por algo propietario como hace NVidia. Pero bueno ya veremos…

Y a que juegos vamos a jugar si pc lleva 6 años estancado graficamente , desde el crysis del 2007 no salio ningún juego que lo supere graficamente , son todos juegos hechos para consola que luego son pegados en pc , nvidia o ati pueden sacar placas graficas con memoria flash, pero los juegos están recortados, así que no sirven para nada jua jua jua .El anuncio de nvidia es solo humo , salvo que alguna compañía empiece a desarrollar juegos para pc que puedan aprovechar dicho potencial , y hasta hoy lamentablemente nadie dio ninguna anuncio sobre el tema, el resto es simplemente tirar el dinero .

Donde estan las graficas NVidia hoy en dia?

No creen en su perdida de competitividad? Miren esto:

http://www.tomshardware.com/reviews/gaming-graphics-card-review,3107.html

Lo mismo le esta pasando con sus chip Tegra.

NVidia viene prometiendo mucho a los clientes y cumpliendo poco.

Habrá que esperar para ver que nuevas características nos proveen para aplicaciones científicas de cálculos de una complejidad que requieren gran poder de procesamiento y paralelísmo.Aunque las tarjetas de GPUś que tenemos hoy en día tienen muy buenas prestaciones para requerímientos específicos.